智谱Agent解读

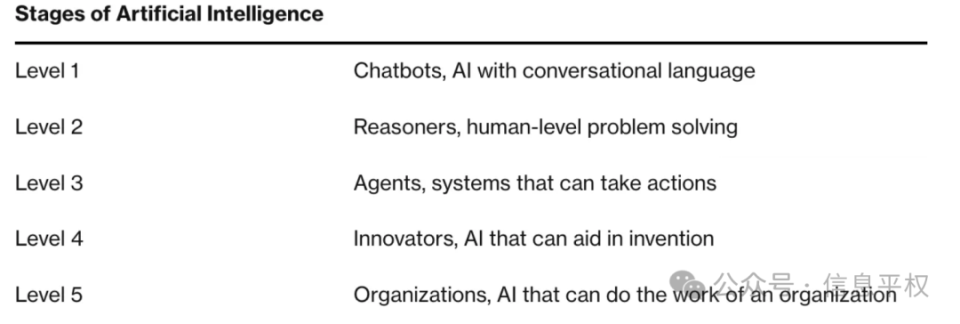

(昨天ChaNg1o在社群分享的,很硬核,也可能是全网最先去解读的。之前智谱发布的手机Agent,有智谱大佬更新在了社群,这次的新发布,回头找他再来给大家科普下)QwQ(通义千问的推理模型)类似的LRM(大型推理模型)的经济效益远没有Agent带来的多。现在的AI进入了OpenAI定义的L3(下图),可以使用工具,reasoning model(推理模型)与Agent将在2025年爆发。

1. 智谱Agent现在支持自动操作超过50步,这涉及了多步、事件循环跨App操作,通过App Links实现应用之间的跳转。这也会涉及更多的屏幕上下文信息。说明多个App情景中的CoAT(chain of action thought,动作-思维链)稳定可用,已经可以利用更多的上下文,在App之间联动跳转。2. GLM记住了更多的屏幕,“哦这个界面是美团,下一个是饿了么,记得执行完饿了么的动作之后,我得回来继续执行美团的”,每个App的动作进行了隔离,也就是记忆追踪任务进度和环境的状态,保持了记忆的一致性,说明需要多代理。之前需要从1到9逐个执行,现在可以执行1,3,6跳转执行了。3. 网页助理,也就是WebAgent。学习了WebGLM-QA数据集的知识然后放在情境中进行学习的AutoWebGLM,强化学习通过CL(课程学习)上课,来理解操作和结果的关联,之后在错误中学习,自己鞭策自己学习,更新的数据集通过RFT(拒绝采样微调)生成多个答案,评分出最好的答案,来筛选并强化模型。这样就可以输出满足用户需求的命令了。通过浏览器的扩展就有权限操作浏览器了。在执行阶段,模型通过阅读抽取更简单扼要的HTML内容,并通过截屏OCR,共同判断,来选择元素,进行语法分析,最后根据用户的需求来生成JavaScript命令,让扩展传递到浏览器执行。4. GLM-PC:将OCR和Label-Action关联下的数据集推广到电脑上。因为桌面端权限更高(相比手机),可以不模仿人类鼠标键盘操作,转而直接通过系统级别的Windows API操作,比如 Windows UI Automation。而安全性隐私方面在模型的数据集方面就有考虑。宣传片中在视频会议那段麦克风和摄像头是关闭的,而且上方有暂停、结束的按钮。通过听写语音转写,然后总结,就可以Agent开会议了。后面例子是总结英伟达的财报,进行了两个软件的联动,直接拖进去就可以了,这就是用了API,而不是通过输出JSON来模拟键盘、鼠标行动。这也带来了稳定性的问题,UI元素不全是方便抽取的,所以需要集成多模态输入,也就是CogAgent(智谱的视觉GUI模型)干的活。Claude的Computer Use需要鼠标的坐标来实现动作。5. 为什么智谱最先在安卓试水呢?因为权限相比较更严格,XML结构最简单可控,一般只有一个屏幕,且像素一般来说更低,容纳的UI的元素更少,但是手势更多,而桌面端则是反过来的。最先提出LLM作为大脑核心的GUI Agent是在浏览器环境下的WebAgent,因为文档对象是结构化的数据,这个LLM擅长。然后是移动端的安卓MM-Navigator,需要一定程度视觉能力。最后才是PC,需要GPT-4级别视觉能力的UFO(UI-focus)。 1. 语言动作模型LAM的基底模型一般是紧凑的,参数一般在10亿到70亿,这比端侧大语言模型LLM更有性价比,善与执行长期的任务。(小模型是未来,不仅仅是成本问题,模型本身在多样化,大型语言模型不再是唯一答案)2. AutoGLM的多模态方向。跨平台,分离了规划和动作的Agent,是未来的方向,现在是更好的CoAT思维行动链,而之后决策的搜索技术MCTS也会有。1. 如何高效扩展GUI Agent的基准测试,现在的评估还需要涉及很多手动方法,这不能实现在任何App都能安全有效的Agent2. 隐私与数据合规。安全性如何保证不出错和出错后的责任划分。这需要本地和云端模型的共同协作,如何压缩模型, 如何利用联邦学习,差分隐私等,来进行本地高效推理、脱敏信息,让模型从用户数据中学习