1.baidu推出Vidu 1.5,揭示视觉模型进入上下文时代,具备对上下文的深刻理解、记忆等能力。

2.Vidu 1.5率先攻克多主体一致性难题,允许用户上传自定义角色图并进行特定动作。

3.除此之外,Vidu还支持多个主体之间的互动,以及融合不同主体特征,创造出全新的角色或物体。

4.通过不断扩展上下文长度,Vidu 1.5展现了视觉模型全新的智能涌现,具备强大的上下文学习能力。

5.由此,视觉模型将具备更强的认知能力,成为AGI的一块重要拼图,加速其到来。

以上内容由腾讯混元大模型生成,仅供参考

Vidu 1.5的推出,揭示了一个重要现象:视觉模型与语言模型一样,经过充分的训练,模型能够展现出对上下文的深刻理解、记忆等能力,这是视觉模型智能涌现的显著特征,这也标志着视觉模型进入全新的“上下文”时代,加速AGI的到来。

持续引领“一致性”突破

率先攻克“多主体一致性”难题

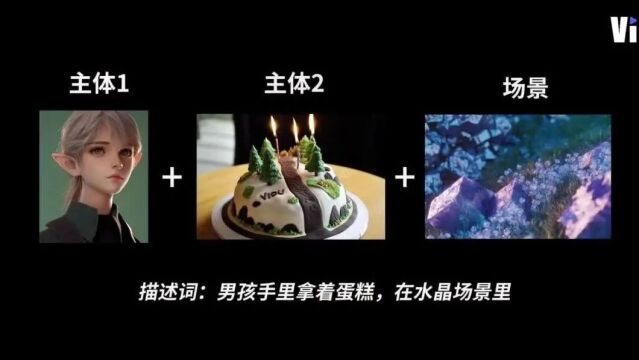

复杂主体的精准控制:无论是细节丰富的角色,还是复杂的物体,Vidu都能保证其在多个不同视角下的一致性。举个例子,造型复杂的3D动画风格角色,无论视角如何变化,Vidu始终确保头型、服饰的全角度细节一致,避免了传统视频模型在复杂视角切换时产生的瑕疵。 人物面部特征和动态表情的自然一致:在人物特写镜头中,Vidu能够自然且流畅地保持人物面部特征和表情的连贯性,避免了面部僵硬或失真的现象。精细的面部控制使Vidu在创作细腻、真实角色时具有显著的优势。 多主体一致性:Vidu允许用户上传多个主体图像,包括人物角色、道具物体、环境背景等,并在视频生成中实现这些元素的交互。例如,用户可以上传主体、客体和环境的图片,创建定制角色身穿特定服装、在定制空间内自由动作的场景。Vidu还支持多个主体之间的互动,用户可以上传多个自定义角色,让它们在指定空间内进行交互。此外,Vidu还支持融合不同主体特征,例如将角色A的正面与角色B的反面无缝融合,创造出全新的角色或物体。

视觉模型进入“上下文时代”

通过不断扩展上下文长度,Vidu从1.0迭代到1.5后,出现了明显的智能涌现效应,模型能够通过视觉上下文完成大量新任务的直接生成。从单输入主体的文/图生视频,到多输入参考信息,未来还将以更长、更丰富的上下文作为输入,进一步提升模型的能力表现。

在拥有处理更复杂任务能力的同时,Vidu1.5延续了其业界领先的生成效率,不到30s即可生成一段视频。

无微调、大统一架构方案

秉承通用性的理念,Vidu有和LLM一致的设计哲学:

统一问题形式:LLM 将所有问题统一为(文本输入,文本输出),Vidu 则将所有问题统一为(视觉输入,视觉输出);

统一架构:LLM 和 Vidu 均用单个 Transformer 统一建模变长的输入和输出;

压缩即智能:LLM 从文本数据的压缩中获取智能,Vidu 从视频数据的压缩中获取智能。

图:技术架构方案

过往的视频模型如果想实现诸如一致性生成的能力,均需要针对每一个场景设计相应的模型进行微调,而无法像语言模型一样,通过上下文学习(In-Context Learning)基于少量的示例或提示快速适应新任务。

视觉智能的涌现加速AGI的到来